Transformer、Bert、GPT简介

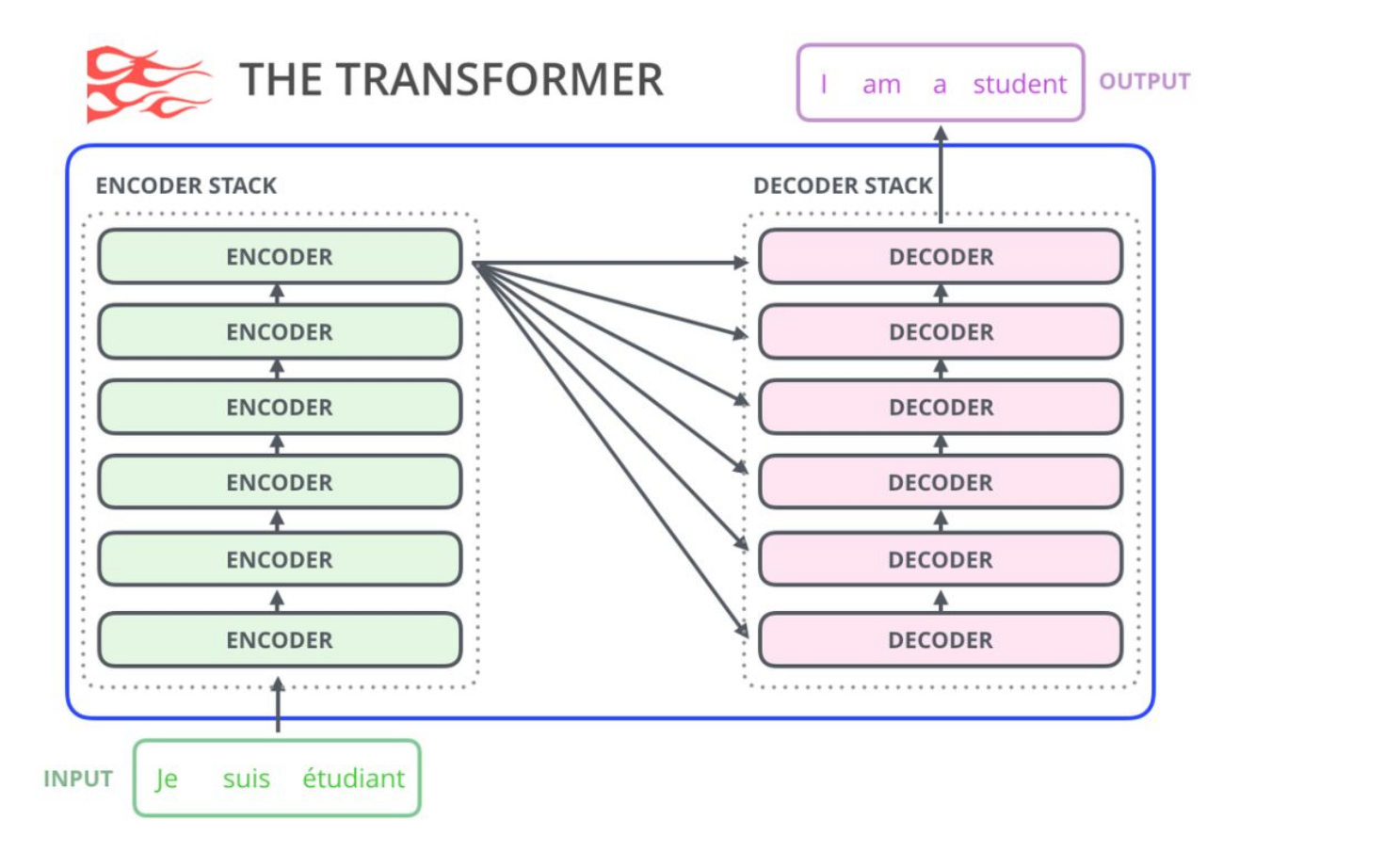

trasformer

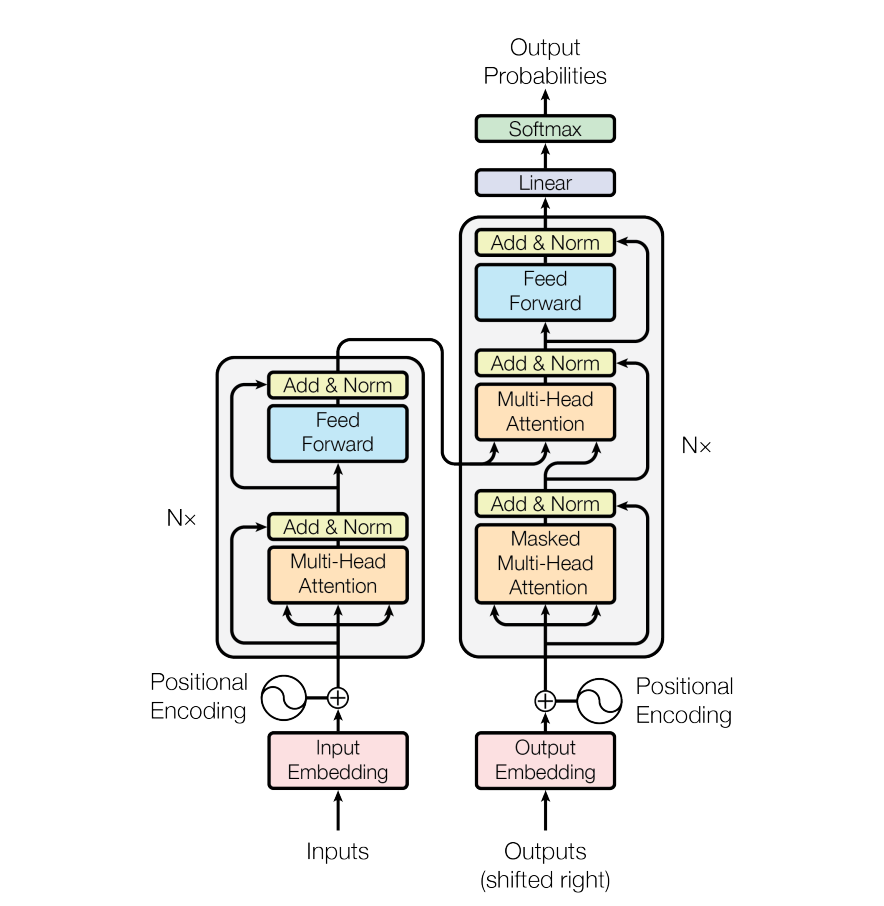

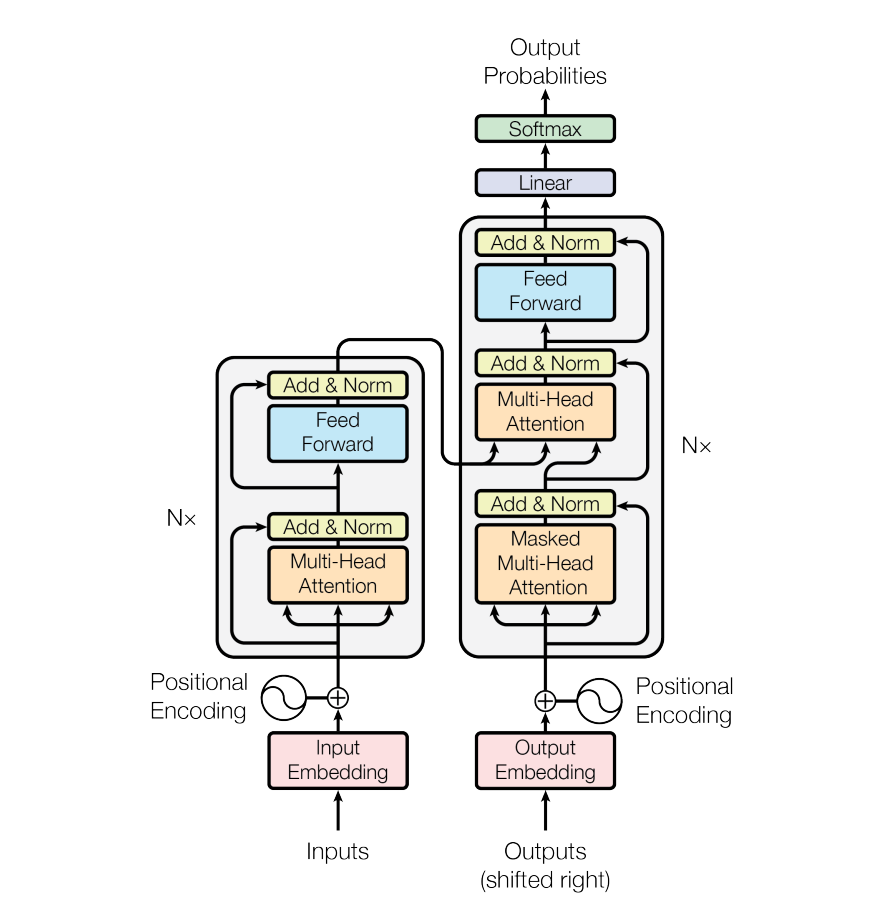

简单回顾一下,encoder将token编码处理,得到embedding.然后送入decoder。decoder的input是前一个时间点产生的output。

Masked Multi-Head Attention,Masked的意思是,在做self-attention的时候,这个decoder只会attend到已经产生的sequence(这个sequence长度和encoder的输出长度不一样),因为没有产生的部分无法做attention

BERT

结构:

BERT只使用了transformer的encoder部分.

input: token embedding +segment embedding + position embedding

会将输入的自然语言句子通过WordPiece embeddings来转化为token序列。之所以会有segment embedding是因为bert会做NSP(next sentense prediction)任务,判断两个句子间的关系,需要sentense级别的信息

output:为预测这些被遮盖掉的token,被mask掉的词将会被输入到一个softmax分类器中,分类器输出的维度对应词典的大小。

GPT

GPT 预训练的方式和传统的语言模型一样,通过上文,预测下一个单词;GPT 预训练的方式是使用 Mask LM。

例如给定一个句子 [u1, u2, …, un],GPT 在预测单词 ui 的时候只会利用 [u1, u2, …, u(i-1)] 的信息,而 BERT 会同时利用 [u1, u2, …, u(i-1), u(i+1), …, un] 的信息

结构

GPT只使用了transformer的decoder部分,并去掉了第二个multi self attention layer

叼茂SEO.bfbikes.com

不错不错,我喜欢看 https://www.jiwenlaw.com/

怎么收藏这篇文章?

看的我热血沸腾啊www.jiwenlaw.com

独家揭秘:全新开服传奇私服,超震撼体验,玩家必玩火爆大服!:https://501h.com/heji/2024-08-16/28283.html

你的文章内容非常卖力,让人点赞。 https://www.yonboz.com/video/86792.html

《爱神》喜剧片高清在线免费观看:https://www.jgz518.com/xingkong/14381.html

你的文章充满了欢乐,让人忍不住一笑。 http://www.55baobei.com/JZk8M9BLlm.html

《魔岛迷踪》恐怖片高清在线免费观看:https://www.jgz518.com/xingkong/141508.html

字里行间流露出真挚的情感,让人感同身受,共鸣不已。

?创新性评语?

?金句式评语?

文章紧扣主题,观点鲜明,展现出深刻的思考维度。

内容的丰富性和深度让人仿佛置身于知识的海洋,受益匪浅。

新车首发,新的一年,只带想赚米的人coinsrore.com

2025年10月新盘 做第一批吃螃蟹的人coinsrore.com

新车新盘 嘎嘎稳 嘎嘎靠谱coinsrore.com

新车首发,新的一年,只带想赚米的人coinsrore.com

新盘 上车集合 留下 我要发发 立马进裙coinsrore.com

做了几十年的项目 我总结了最好的一个盘(纯干货)coinsrore.com

新车上路,只带前10个人coinsrore.com

新盘首开 新盘首开 征召客户!!!coinsrore.com

新项目准备上线,寻找志同道合的合作伙伴coinsrore.com

新车即将上线 真正的项目,期待你的参与coinsrore.com

新盘新项目,不再等待,现在就是最佳上车机会!coinsrore.com

新盘新盘 这个月刚上新盘 新车第一个吃螃蟹!coinsrore.com

如何申请华纳公司账户?

华纳东方明珠客服电话是多少?(▲18288362750?《?微信STS5099? 】

如何联系华纳东方明珠客服?(▲18288362750?《?微信STS5099? 】

华纳东方明珠官方客服联系方式?(▲18288362750?《?微信STS5099?

华纳东方明珠客服热线?(▲18288362750?《?微信STS5099?

华纳东方明珠24小时客服电话?(▲18288362750?《?微信STS5099? 】

华纳东方明珠官方客服在线咨询?(▲18288362750?《?微信STS5099?

新盛客服电话是多少?(?183-8890-9465—《?薇-STS5099】【

新盛开户专线联系方式?(?183-8890--9465—《?薇-STS5099】【?扣6011643??】

新盛客服开户电话全攻略,让娱乐更顺畅!(?183-8890--9465—《?薇-STS5099】客服开户流程,华纳新盛客服开户流程图(?183-8890--9465—《?薇-STS5099】

果博东方客服开户联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方公司客服电话联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方开户流程【182-8836-2750—】?薇- cxs20250806】

果博东方客服怎么联系【182-8836-2750—】?薇- cxs20250806】

果博东方客服开户联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方公司客服电话联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方开户流程【182-8836-2750—】?薇- cxs20250806】

果博东方客服怎么联系【182-8836-2750—】?薇- cxs20250806】

果博东方客服开户联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方公司客服电话联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方开户流程【182-8836-2750—】?薇- cxs20250806】

果博东方客服怎么联系【182-8836-2750—】?薇- cxs20250806】

果博东方客服开户联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方公司客服电话联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方开户流程【182-8836-2750—】?薇- cxs20250806】

果博东方客服怎么联系【182-8836-2750—】?薇- cxs20250806】

华纳圣淘沙开户步骤详解(183-8890-9465—?薇-STS5099【6011643】

华纳圣淘沙公司开户流程全解析(183-8890-9465—?薇-STS5099【6011643】

华纳圣淘沙公司账户注册指南(183-8890-9465—?薇-STS5099【6011643】

新手如何开通华纳圣淘沙公司账户(183-8890-9465—?薇-STS5099【6011643】

华纳圣淘沙企业开户标准流程(183-8890-9465—?薇-STS5099【6011643】

华纳圣淘沙公司开户:从零到一(183-8890-9465—?薇-STS5099【6011643】

官方指南:华纳圣淘沙公司开户流程(183-8890-9465—?薇-STS5099【6011643】

华纳圣淘沙公司开户流程说明书(183-8890-9465—?薇-STS5099【6011643】

华纳圣淘沙公司开户新手教程

零基础学会(183-8890-9465薇-STS5099)

华纳圣淘沙公司开户

华纳圣淘沙公司开户保姆级教程(183-8890-9465薇-STS5099)

一步步教你开通华纳圣淘沙公司账户(183-8890-9465薇-STS5099)

华纳圣淘沙公司开户分步图解

首次开户必看:(183-8890-9465薇-STS5099)

华纳圣淘沙全攻略

华纳圣淘沙公司开户实操手册(183-8890-9465薇-STS5099)

华纳圣淘沙开户流程视频教程

手把手教学:(183-8890-9465薇-STS5099)

华纳圣淘沙公司开户

华纳圣淘沙公司开户完全指南(183-8890-9465薇-STS5099)

华纳公司官方开户渠道?(183-8890-9465)-薇-STS5099【6011643】

如何通过官方渠道申请华纳公司账户?(183-8890-9465)-薇-STS5099【6011643】

华纳总公司官方开户指南?(183-8890-9465)-薇-STS5099【6011643】

华纳公司官方开户所需材料?(183-8890-9465)-薇-STS5099【6011643】

华纳官方开户流程?(183-8890-9465)-薇-STS5099【6011643】

华纳公司官方开户申请步骤?(183-8890-9465)-薇-STS5099【6011643】

华纳官方开户指南?(183-8890-9465)-薇-STS5099【6011643】

华纳总公司官方开户?(183-8890-9465)-薇-STS5099【6011643】

华纳公司官方开户所需材料?(183-8890-9465)-薇-STS5099【6011643】

华纳官方开户申请流程?(183-8890-9465)-薇-STS5099【6011643】

春风阁cfg999优惠怎么领a0heb.cn