多模态AI

Transformer模型

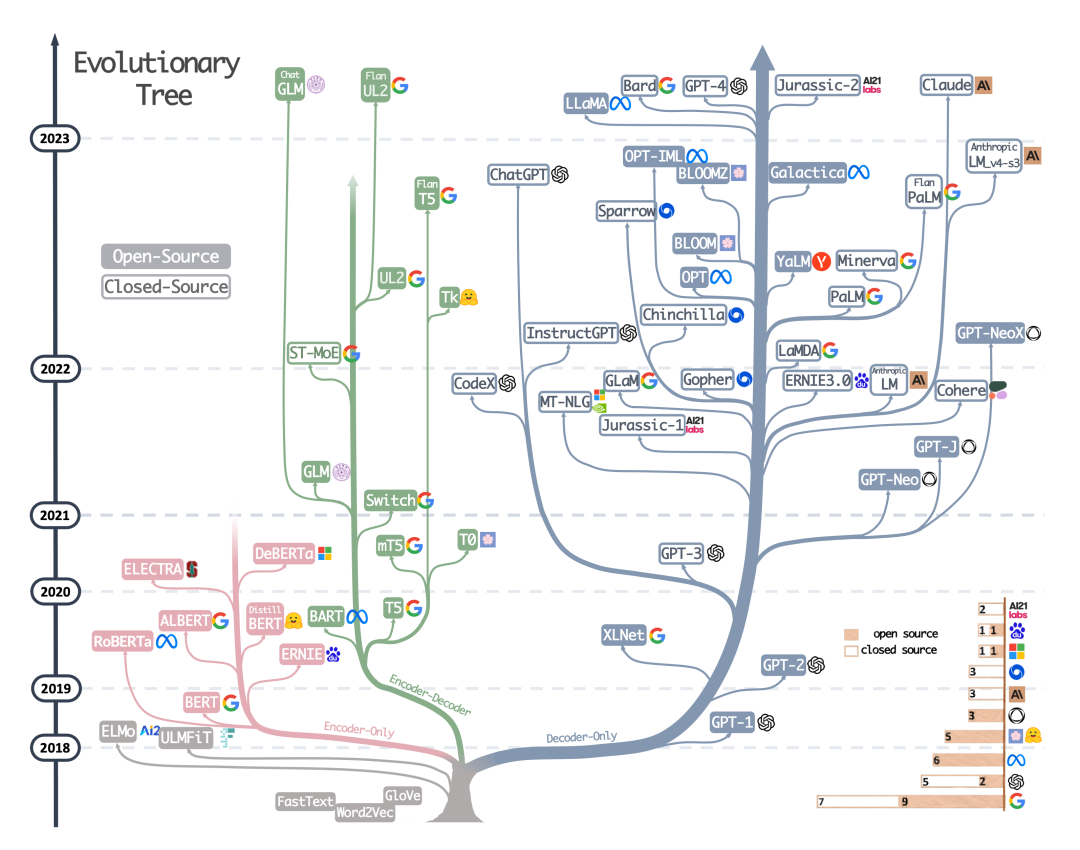

来自Yang, JF et al., Harnessing the Power of LLMs in Practice: A Survey on ChatGPT and Beyond。

今天多模态AI的技术进展状态,像极了2017年前后的NLP领域。

2017年是Google提出Transformer技术的时间,也是NLP科研领域百花齐放,多路径同时迭代,上下游任务各自突破的时代。在自然语言处理顶级学术会议ACL 2017年的论文列表(https://aclanthology.org/events/acl-2017/)中,我们可以找到那个时代科研人员最关心的技术话题。

2017年,文本分类、语义解析(Semantic Parsing)、向量编码、机器翻译、文本生成、阅读理解、知识问答、主题模型、方面提取(Aspect Extraction)等等上下游任务与Attention、RNN、CNN、Sequence-to-sequence、Sequence-to-Dependency等不同技术路线之间以各种方式排列组合,让人目不暇给。即便是进入了2018年的BERT时代,科研圈的很多人还是在反复争论到底哪一种路线才是通往“人工智能圣杯”的最优路径。

概念上,多模态AI指的是能够执行一种或多种跨模态/多模态任务的AI算法。典型的跨模态/多模态任务(科研上,“跨模态”与“多模态”有不同的内涵,本文不做详细说明)包括:

跨模态的生成任务,如文生图;

输出多模态信息的生成任务,如根据文字描述,自动输出混合了图、文、视频内容的展示文稿;

跨模态的理解任务,如自动为视频编配语义字幕;

跨模态的逻辑推理任务,如根据输入的几何图形,给出有关定理的文字证明;

多模态的逻辑推理任务,如请AI玩密室逃脱——这需要AI根据密室空间结构,文字信息,图片信息等推理出最优解决方案;

……

叼茂SEO.bfbikes.com

看的我热血沸腾啊https://www.ea55.com/

想想你的文章写的特别好www.jiwenlaw.com

文章的确不错啊https://www.cscnn.com/

你的文章让我心情愉悦,每天都要来看一看。 http://www.55baobei.com/GM5Ca2mGDT.html

你的文章充满了欢乐,让人忍不住一笑。 http://www.55baobei.com/9DKVBiMVWU.html

你的文章充满了欢乐,让人忍不住一笑。 https://www.yonboz.com/video/80391.html

哈哈哈,写的太好了https://www.lawjida.com/

文章深入浅出,既有深度思考,又不乏广度覆盖,令人叹为观止。

在现有基础上可尝试多媒介形式呈现。

文章结构紧凑,层次分明,逻辑严密,让人一读即懂。

首尾呼应,主题鲜明,收束有力。

?文化类评语?

文献引用规范,学术态度严谨,值得借鉴。

?诗歌散文评语?

字里行间流露出真挚的情感,让人感同身受,共鸣不已。

新盘首开 新盘首开 征召客户!!!

2025年10月新盘 做第一批吃螃蟹的人coinsrore.com

新车新盘 嘎嘎稳 嘎嘎靠谱coinsrore.com

新车首发,新的一年,只带想赚米的人coinsrore.com

新盘 上车集合 留下 我要发发 立马进裙coinsrore.com

做了几十年的项目 我总结了最好的一个盘(纯干货)coinsrore.com

新车上路,只带前10个人coinsrore.com

新盘首开 新盘首开 征召客户!!!coinsrore.com

新项目准备上线,寻找志同道合的合作伙伴coinsrore.com

新车即将上线 真正的项目,期待你的参与coinsrore.com

新盘新项目,不再等待,现在就是最佳上车机会!coinsrore.com

新盘新盘 这个月刚上新盘 新车第一个吃螃蟹!coinsrore.com

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司合作开户所需材料?电话号码15587291507 微信STS5099

华纳公司开户注册步骤?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠客服电话是多少?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠开户专线联系方式?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

如何联系华纳东方明珠客服?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠官方客服联系方式?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠客服热线?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠开户客服电话?(▲182(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠24小时客服电话?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠客服邮箱?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠官方客服在线咨询?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠客服微信?(▲18288362750?《?微信STS5099? 】【╃q 2704132802╃】

华纳东方明珠客服电话是多少?(??155--8729--1507?《?薇-STS5099】【?扣6011643?】

华纳东方明珠开户专线联系方式?(??155--8729--1507?《?薇-STS5099】【?扣6011643?】

果博东方客服开户联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方公司客服电话联系方式【182-8836-2750—】?薇- cxs20250806】

果博东方开户流程【182-8836-2750—】?薇- cxs20250806】

果博东方客服怎么联系【182-8836-2750—】?薇- cxs20250806】

寻找华纳圣淘沙公司开户代理(183-8890-9465薇-STS5099】

华纳圣淘沙官方合作开户渠道(183-8890-9465薇-STS5099】

华纳圣淘沙公司开户代理服务(183-8890-9465薇-STS5099】

华纳圣淘沙公司开户咨询热线(183-8890-9465薇-STS5099】

联系客服了解华纳圣淘沙开户

(183-8890-9465薇-STS5099】

华纳圣淘沙公司开户专属顾问

(183-8890-9465薇-STS5099】

华纳公司官方开户渠道?(183-8890-9465)-薇-STS5099【6011643】

如何通过官方渠道申请华纳公司账户?(183-8890-9465)-薇-STS5099【6011643】

华纳总公司官方开户指南?(183-8890-9465)-薇-STS5099【6011643】

华纳公司官方开户所需材料?(183-8890-9465)-薇-STS5099【6011643】

华纳官方开户流程?(183-8890-9465)-薇-STS5099【6011643】

华纳公司官方开户申请步骤?(183-8890-9465)-薇-STS5099【6011643】

华纳官方开户指南?(183-8890-9465)-薇-STS5099【6011643】

华纳总公司官方开户?(183-8890-9465)-薇-STS5099【6011643】

华纳公司官方开户所需材料?(183-8890-9465)-薇-STS5099【6011643】

华纳官方开户申请流程?(183-8890-9465)-薇-STS5099【6011643】

初中生微信群二维码a0hd.cn